Da IlSole24Ore

Ecco The Machine, l'architettura del computer di domani per l'Internet delle cose e i Big Data

di Gianni Rusconi, 16 giu 2014

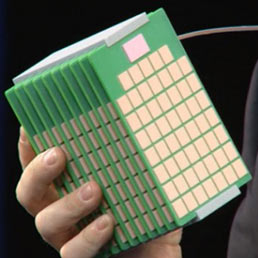

Speciali microchip, memorie non volatili e reti fotoniche: questi gli ingredienti che Hewlett Packard ha messo insieme per dare vita a un "oggetto" che nelle intenzioni dovrebbe reinvetare il paradigma del computing. L'oggetto in questione si chiama "The Machine" e la casa californiana lo ha svelato pubblicamente per la prima volta, dopo due anni di lavoro nei suoi Labs di Palo Alto, in occasione dell'evento Discover 2014, tenutosi a Las Vegas la scorsa settimana.

Debutto sul mercato nel 2016

A battezzare il prototipo della "Macchina" c'era pure il Ceo di Hp, Meg Whitman, che non ha certo omesso di descrivere il progetto in questione come un'innovazione che cambierà la storia dell'informatica, focalizzando il suo intervento sulla questione dei dati. Affrontare e vincere la sfida dei Big Data significa trovare la formula di computing più adeguata per archiviarli e gestirli senza far lievitare costi, tempistiche e consumi energetici per spostare le informazioni in formato digitale da un luogo all'altro.

Il Cto della società, Martin Fink, è entrato nello specifico dei benefici che "The Machine" può in tal senso generare: riduzione del 77% degli oneri di gestione dell'It, taglio fino all'89% dell'energia e saving dell'80% in fatto di spazio. Il tutto condito da una semplicità d'uso che non ha eguali rispetto ai sistemi di storage attuali. The Machine è la risposta a tendere a queste problemamtiche. La sua sperimentazione è fissata per il 2015 e dal 2016/2018 dovrebbe diventare un prodotto commerciale a tutto gli effetti, debuttando a bordo di Moonshot, la linea di server software-defined di Hp già in commercio.

Un continuum di più sistemi hardware

L'idea di fondo di Hp è in buona sostanza quella di ridefinire l'architettura hardware e software alla base dei processi di archiviazione, trasmissione ed elaborazione delle informazioni. Per questo entrano in gioco le capacità delle reti fotoniche, per velocizzare il trasferimento dei dati, e dei "memristor", e cioè speciali memorie (una sorta di combinazione fra Dram e tecnologie flash memory) che promettono storage a super velocità con costi minimi perchè capaci di archiviare dati in modo non volatile, in assenza di energia. A livello software, inoltre, Hp si impegnerà a sviluppare un sistema operativo ad hoc in ambiente Linux che servirà a far funzionare questa architettura ma ha parlato anche di una versione ottimizzata di Android già in fase di progettazione, che porterebbe gli smartphone di nuova generazione a dotarsi di una capacità di storage di 100 terabyte.

The Machine, come ha spiegato la Whitman, "non è un server, un notebook o un mainframe ma un continuum che include tutti questi elementi". Un nuovo paradigma, per l'appunto, che tecnicamente si potrebbe descrivere come un'architettura basata su cluster di processori specializzati (piuttosto che tanti core "general purpose") e un pool di memorie che comunicano fra loro grazie alla tecnologia fotonica, e quindi la luce (piuttosto che i fili in rame). "Gli elettroni calcolano, i fotoni comunicano, gli ioni archiviano. In queste sei parole è racchiuso il funzionamento di The Machine": la sottolineatura del Cto di Hp è forse una delle sintesi più azzeccate per descrivere le qualità di un nuovo prodotto informatico. Che difficilmente sarà integrato a mò di super scheda madre dentro un computer tradizionale, bensì prenderà servizio nei data center all'interno di server e moduli rack, a supporto delle applicazioni per i Big Data e nel mondo dell'Internet delle cose e del machine to machine.

Quel che è certo, e sulla carta effettivamente rivoluzionario, è che Hp si appresta a mettere sul tavolo dei Chief information officer una soluzione in grado di "gestire insiemi di dati di enormi dimensioni, archiviarli e manipolarli usando moltissima energia in meno per bit o per sessione calcolo".

Un singolo modulo di "The Machine" potrà gestire 160 petabyte di dati in 250 nanosecondi, con un hardware circa sei volte più potente di un server attuale e un consumo di energia 80 volte inferiore.

Il sasso nello stagno è lanciato.

Nessun commento:

Posta un commento